Künstliche Intelligenz: Nutzen und Risiken

Seit Jahren steigt der Einsatz von Künstlicher Intelligenz (KI), längst ist sie im Alltag der Menschen angekommen und wird weiter zunehmen, nicht nur in der Wirtschaft und in unseren elektronischen Geräten, sondern auch in der öffentlichen Verwaltung.

Mit KI werden viele positive Erwartungen verbunden, schneller und besser sollen damit Aufgaben erledigt werden können und sie soll neutraler sein, wenn sie Entscheidungen trifft, ohne menschliche Einflussnahme. Tatsächlich gibt es viele Beispiele, wo KI Prozesse verbessert und beschleunigt hat, z.B. bei der Erkennung von Hautkrebs anhand von Bildern. Aber die “Neutralität” von KI ist vor allem eins: ein hartnäckiger Mythos. Selbstlernende Systeme werden mit Daten gefüttert und trainiert, die eine nicht neutrale Gesellschaft wiederspiegeln – mitsamt ihren Vorurteilen und Stereotypen. Die Daten werden gesammelt und bereitgestellt von Menschen, die ihre Auswahl nicht neutral treffen und die oft selbst alles andere als diverse Abbilder der Gesellschaft sind. KI kann sogar bestehende Ungleichheiten verstärken, in dem sie Diskriminierung zur Regel macht.

Auch wenn KI nicht für genau den Zweck eingesetzt wird, für den sie trainiert wurde, kann sie zu falschen Ergebnissen kommen. Eine falsche Entscheidung ist nicht immer gleich schlimm, denn wenn eine KI die eingehenden Emails einer Behörde in die virtuellen Postkörbe einzelner Fachkräfte verteilt, sind Folgerisiken einer falschen Entscheidung überschaubar. Macht sie jedoch Fehler, wenn Entscheidungen mit schwerwiegenden Folgen, vielleicht sogar mit unkorrigierbaren Folgen für Leib und Leben verbunden sind (z.B. bei bewaffneten Drohnen) dann sind die Risiken ihres Einsatzes ungleich höher. Risiken des Einsatzes Künstlicher Intelligenz ergeben sich vor allem dann, wenn sie Menschen in Gruppen einteilt und es anhand dieser Gruppenzuordnung zu unterschiedlicher Behandlung kommt. Eine solche Gruppeneinteilung muss nicht einmal Absicht sein, sondern ergibt sich häufig aus den Daten, die für das Training der Systeme eingesetzt wurden. Dies zeigt sich häufig an von Geschlecht und Ethnie abhängigen Fehlerquoten, z.B. bei häufigerer Einstufung Unschuldiger als Verdächtige.

Für die Öffentliche Verwaltung gelten hohe Standards hinsichtlich eines verantwortungsbewussten Einsatzes risikobehafteter Technologien. Eine Vielzahl wichtiger aber offener Fragen nach gesellschaftlichen, politischen und rechtlichen Rahmen rund um den Einsatz von KI haben in der letzten Legislatur die Bundesregierung mit der Datenethikkommission und der Bundestag in der Enquete Kommission KI debattiert. Beide Gremien, aber auch die EU-Kommission haben eine Reihe von Empfehlungen erarbeitet. Alle Gremien waren sich einig: es gibt erhebliche Risiken, sie müssen minimiert und untersucht werden und der Einsatz KI erfordert eine breite gesellschaftliche Debatte.

Meine Kleine Anfrage: Wie berücksichtigt die BuReg Risiken beim Einsatz von KI?

Ich habe deshalb eine Kleine Anfrage an die Bundesregierung gestellt, um vor allem zwei Fragen zu klären:

- Wie umfassend ist bereits der Einsatz von KI auf Bundesebene? Wo wird sie und wofür eingesetzt?

- In welcher Weise wurden dabei die Empfehlungen der Gremien zur Risikoabwägung berücksichtigt?

Für die erste Fragestellung wollte ich wissen, wo, von wem und zu welchem Zweck ein KI-System genutzt wird, ob es Bewertungen, Empfehlungen oder Entscheidungen vornimmt und ob es das allein – also vollautomatisch tut. Ich habe außerdem gefragt, was die jeweilige Datenbasis für die KI ist.

Meine zweite Fragestellung war zweiteilig und recht klar formuliert:

„Werden oder wurden Risikoklassenmodelle angewendet, um Entscheidungen für oder gegen den Einsatz eines selbstlernenden Systems zu treffen?

2 a) Wenn ja: welche(s) Risikoklassenmodell(e) wurde(n)n angewendet und in jeweils welchen Fällen?

2 b) In welchen dieser Fälle kam es nach Bewertung mittels Risikoklassenmodell zu einer Entscheidung gegen den Einsatz eines selbstlernenden Systems und warum?“

Die Antwort der Bundesregierung hat mich erschüttert, denn obwohl aus ihr hervorgeht, dass selbstlernende Systeme mehr als 80 Mal von Bundesbehörden genutzt werden (Antwort auf Fragekomplex 1), fand offenbar nur ein einziges Mal eine Risikobewertung anhand eines Risikoklassenmodells statt, wie es z.B. die Datenethikkommission empfiehlt (siehe Antwort auf Fragekomplex 2).

Zu den 86 angegebenen Anwendungsbeispielen für KI kommen noch 190 weitere Forschungsvorhaben, Pilotprojekte und Reallabore im Volumen von insgesamt 1,8 Mrd. Euro, (siehe Anlage 3) die deutlich machen, dass diese Entwicklung sich beschleunigt, dass es also höchste Zeit ist, Prozesse zu etablieren, die einen Einsatz von KI begleiten, oder falls die Risiken unvertretbar sind, einen solchen Einsatz nicht zuzulassen oder wieder zu beenden. Besonders gravierend ist der Umstand zu bewerten, dass nicht einmal ein rudimentäres Verständnis für die Risikobewertung im Zusammenhang mit KI vorhanden zu sein scheint, weder bei den jeweiligen Institutionen des Bundes, die mit völlig unpassenden Antworten ihre Ahnungslosigkeit zum Thema offenbarten, noch beim BMBF, das diese Antworten zusammengefasst und kommentiert an mich weitergab, ohne diesen offensichtlichen Missstand zu erkennen und um eine Korrektur zu bitten, bevor ein derart peinliches Papier das Licht der Öffentlichkeit erblickt. Einen vollständigen Überblick scheint es ohnehin nicht zu geben, denn in ihrer Vorbemerkung gibt die Bundesregierung zu:

„…Ermittlung der erfragten Angaben für alle diese Vorhaben ist nicht vollumfänglich möglich.”

Völlig unpassende Antworten offenbaren Inkompetenz bei Risikobewertung von KI

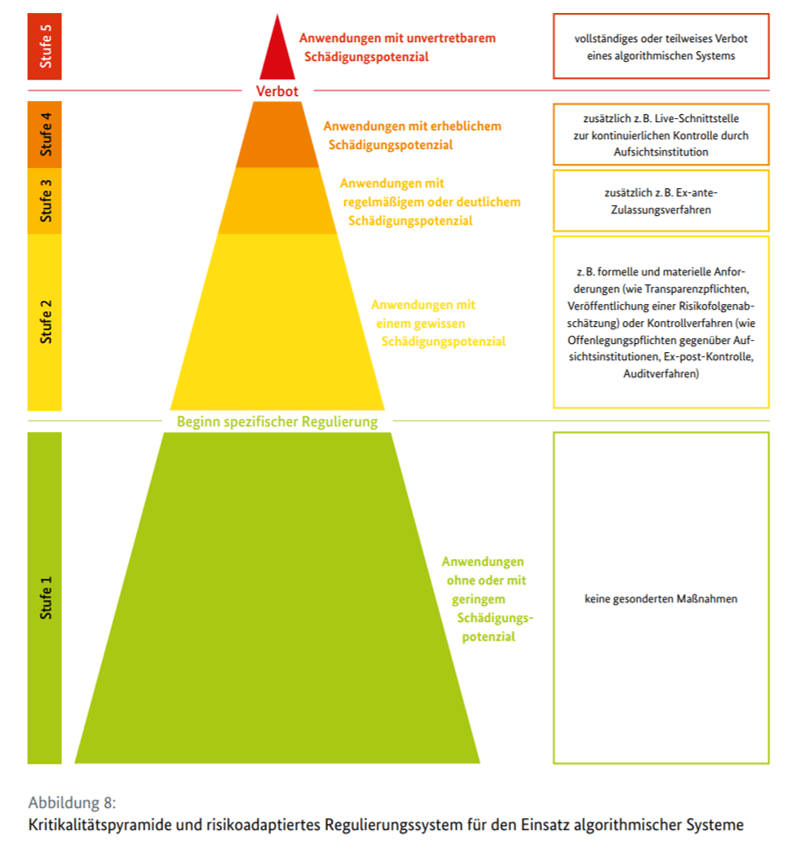

Ein Risikoklassenmodell bewertet konkret die Risiken eines Einsatzes von KI und soll eine Entscheidung darüber ermöglichen, ob und wenn ja unter welchen ggf. einschränkenden Bedingungen ein selbstlernendes System für einen ganz bestimmten Zweck eingesetzt werden darf. Es geht also um ein Risiko DURCH den Einsatz von KI, nicht etwa darum, welche Risiken die KI selbst zu irgendeinem beliebigen Sachverhalt bewerten soll. Ein Risikoklassenmodell ermöglicht nach einheitlichen Kriterien die Einstufung von KI-Systemen in verschiedene Risikokategorien. Die nachfolgende Graphik zeigt die 5 Kritikalitätsstufen für KI-Systeme, die die Datenethikkommission in ihrem Abschlussbericht empfahl. Sie zeigt auch, welche Konsequenzen sich für den Einsatz eines KI-Systems von dieser Einstufung ableiten:

Wenn dann das Robert Koch Institut (nachgeordnete Behörde des BMG) in seiner Antwort auf die Frage nach der Beurteilung eingesetzter KI anhand eines Risikoklassenmodells schreibt, dass es entscheidet

„zwischen den Risikoklassen ‚frisch infiziert‘ und ‚Infektion liegt mehr als 6 Monate zurück“,

dann wird klar, dass sie die Frage nicht verstanden haben und ihnen das Konzept von Risikoklassenmodellen zur Bewertung von KI-Systemen völlig fremd ist. Schließlich geht es hier nicht um Gesundheitsrisiken durch Vireninfektionen, sondern um Risiken durch den Einsatz von KI-Systemen. Das RKI steht damit leider nicht allein. Auch das Bundesamt für Strahlenschutz glänzt mit einer “Thema verfehlt” Antwort und schrieb,

und verwechselt die Bewertung von Risiken durch Strahlung mit der eigentlich gefragten Bewertung von Risiken durch KI-Systeme.

Das ist nicht im Ansatz das, was mit der Frage nach Risikoklassenmodellen gemeint ist, denn ein standardisiertes Risikoklassenmodell sollte nach einheitlichen Kriterien eine Entscheidung ermöglichen, ob ein KI-System überhaupt eingesetzt werden darf und, welche Bedingungen es bei einem zulässigen Einsatz erfüllen muss.

Nur für 6 von 86 aufgelisteten Anwendungsfällen wurde angegeben, dass ein Risikoklassenmodell zur Anwendung kam – die meisten dieser 6 Anwendungsbeispiele waren Varianten, wie die beiden zitierten, also am Thema komplett vorbei. Nur das Statistische Bundesamt hatte die Frage verstanden und beantwortet, dort kam ein Risikoklassenmodell “nach dem Vorbild des Entwurfs der KI-Verordnung der Europäischen Kommission zum Einsatz”.

Für 2 weitere Fälle gibt es eventuell eine Risikobewertung der KI, bei Anwendungen im BKA und bei der Bundespolizei, aber dazu “können wegen der VS-NfD-Klassifizierung keine Details zu den angewandten Risikoklassenmodellen angegeben werden”. Das bringt mich zu einem weiteren Problem.

KI-Blackbox: KI-Einsatz von Sicherheitsbehörden bleibt intransparent

Einige Antworten der Bundesregierung wurden mir überhaupt nicht mitgeteilt, nicht einmal mit einer Sicherheitseinstufung, die mich in der Verwendung der Informationen eingeschränkt hätte.

Ich durfte also überhaupt nichts erfahren über:

- alle KI-Systeme beim Bundesamt für Verfassungsschutz

- 2 KI-Systeme beim Bundeskriminalamt (BKA)

Weitere 7 Anwendungsfälle erhielt ich mit der Angabe „Nur für den Dienstgebrauch“, ich darf diese also nicht öffentlich machen und auch nichts darüber schreiben.

Verschweigen muss ich alle Angaben zu:

- 3 KI-Systeme beim ZITiS (Zentrale Stelle für Informationstechnik im Sicherheitsbereich)

- 2 KI-Systeme beim BKA

- 2 KI-Systeme bei der Bundespolizei

Ausgerechnet dort, wo potenziell Grundrechte von Bürger:innen besonders berührt sein können, wo also auch Risiken durch einen fehlerhaften Einsatz von KI besonders hoch sind, wird die parlamentarische Kontrolle sowie die gesellschaftliche Debatte eklatant eingeschränkt. Dies widerspricht dem Grundgedanken aller Empfehlungen der Gremien, die sich mit den ethischen Folgen des Einsatzes von KI befasst haben.

Ein fiktives Beispiel: Wenn etwa völlig unbescholtene Menschen in einer Verdächtigen-Datenbank erfasst werden, weil eine KI zur Gesichtserkennung sich „geirrt“ hat, dann kann das erhebliche Folgen für die Betroffenen haben. Sie und ihre Kontakte und Familien werden vielleicht überwacht, bei Grenzübertritten ständig überprüft (das kann so lange dauern, dass sie vielleicht ihren Anschlussflug verpassen), vielleicht werden ihre Messenger gelesen oder ihre Emails durchsucht. Vielleicht bekommen sie einen Job nicht, weil eine Hintergrundüberprüfung negativ für sie ausfiel. Und alles das kann passieren, ohne dass Betroffene je etwas davon erfahren. Das darf nicht passieren und deshalb ist sowohl eine effektive parlamentarische Kontrolle als auch eine intensive und kritische gesellschaftliche Debatte gerade für den Einsatz von KI-Systemen bei Sicherheitsbehörden enorm wichtig.

Der erwartete Nutzen muss noch genauer überprüft und zwingend ins Verhältnis gesetzt werden zu den potenziellen Nachteilen für Individuen und die Gesellschaft als Ganzes. Der Staat hat ein Machtmonopol, denn anders als beim Amazon-Shopping haben Bürger:innen ihm gegenüber keine Wahlfreiheit. Auch deshalb müssen die ethischen Standards hoch sein und es muss sinnvolle, nachvollziehbare und transparente Prozesse dafür geben, wie sie angewendet werden. Den Mantel des Schweigens und der Intransparenz darüber zu legen, ist falsch und gefährlich, es schürt Misstrauen in die Politik und in die Demokratie und begünstigt den tatsächlich falschen und gefährlichen Einsatz von KI-Systemen, für die nach korrekter Risikoklassifizierung eigentlich gelten müsste, dass sie nicht verwendet werden dürfen.

Man könnte in gewisser Weise KI-Systeme mit Medikamenten vergleichen, für die auch jeweils eine Nutzen versus Nebenwirkungen-Bewertung vorgenommen wird und für die je nach Häufigkeit und Schwere der Nebenwirkungen im Vergleich zum erwarteten medizinischen Nutzen entweder gar nicht erst eine Zulassung erfolgt, oder für die unterschiedlich stark einschränkende Vorgaben gelten (z.B. Einnahme „nicht länger als 1 Woche“ oder „nicht für Schwangere, Stillende und Kinder unter 12“).

Wie sinnvoll wäre es, solche Überprüfungen gerade bei Medikamenten mit potenziell besonders gesundheitsgefährdenden Nebenwirkungen gar nicht erst vorzunehmen, oder ihre Ergebnisse geheim zu halten und sie einfach heimlich ins Trinkwasser zu mischen? Ich finde den Vergleich keineswegs weit hergeholt, denn KI-Systeme haben eben nicht nur ein hohes Nutzenpotenzial, sondern bergen eben auch potenziell gravierende Risiken und wir als Gesellschaft sollten evidenzbasiert entscheiden, welche Risiken wir für welchen Nutzen bereit sind, in Kauf zu nehmen.

Aber nicht nur bei Sicherheitsbehörden und Geheimdiensten sind Grundrechte berührt, denn laut Antwort der Bundesregierung setzt z.B. das BAMF KI-Systeme ein, um Anhörungsniederschriften nach Sicherheitsaspekten zu durchsuchen und sicherheitsrelevante Informationen an Sicherheitsbehörden und Geheimdienste weiterzuleiten. Ein Risikoklassenmodell kam hier offensichtlich nicht zur Anwendung. Das ist völlig inakzeptabel, denn es kann für Asylbewerber:innen verhängnisvolle Folgen haben, wenn eine KI in ihnen ein potenzielles Sicherheitsrisiko sieht. Vielleicht führt der Hinweis der KI dazu, dass man fälschlicherweise an Sicherheitsbehörden gemeldet wird? Jeder weiß ja, wie schwer es ist, von solchen Listen wieder runterzukommen und wie intransparent die Behörden damit umgehen. Bereits 2019 berichtete netzpolitik.org über die massenhaft weitergeleiteten Daten vom BAMF an die Sicherheitsbehörden. Während 2015 nur 500 Personen weitergeleitet wurden, waren es zwei Jahre später – aufgrund der KI-Systeme – bereits Daten von 10.000 (!) Personen.

Wie viele davon relevante Treffer waren? Laut Recherchen von netzpolitig.org ging das BAMF bereits damals von einer Fehlerquote von 15% aus!

Vergabepraxis: Money, Money, Money!

Der Antwort der Bundesregierung ist in ihrer Anlage 2 zu entnehmen, dass in der vergangenen 19. Legislaturperiode fast 100 Millionen Euro Kosten für externe Umsetzung ihrer KI-Projekte entstanden. Viele Aufträge und viel Geld also, das diverse Firmen gern für sich verbuchen wollen. Dabei sind Forschungsvorhaben, Pilotprojekte und Reallabore nicht eingeschlossen, die selbst noch einmal mehr als 1 Mrd Euro Volumen umfassen.Fast Zweidrittel aller extern entwickelten KI-Anwendungen wurden ohne eine öffentliche Ausschreibung beauftragt. Grundlage sind dafür Rahmenverträge, zum Beispiel mit der Firma „System Vertrieb Alexander GmbH“ (SVA), die ohne extra Ausschreibung einen Auftrag über 18,3 Millionen Euro vom BAMF erhielt. Wem der kryptische Firmenname doch irgendwie bekannt vorkommt, ja, das ist genau die gleiche SVA, die bereits in Verbindung mit der sog. “Berateraffäre” vom Untersuchungsausschuss des Verteidigungsausschusses im Deutschen Bundestag eine Rolle spielte und die mir bei meiner schriftlichen Frage zum ID Wallet-Fail der Bundesregierung wieder begegnete.

Ich frage mich, ob derartige Rahmenverträge die speziellen Herausforderungen von KI-Systemen überhaupt hinreichend berücksichtigen (Haftungsfragen, IT-Sicherheitsanforderungen, usw.). Und ich frage mich (wie bei vielen anderen IT-Projektvergabeprozessen), welche Folgen eigentlich der große Mangel an der notwendigen Kombination von Vergabekompetenz mit hinreichender IT-Kompetenz hat – gerade bei derart komplexen Vorhaben.

Ein bisschen Lob gibt’s auch – aber unter Vorbehalt

Viele KI-Projekte der Bundesregierung sind im Gesundheitsbereich zu finden, gerade im Zusammenhang mit der Covid-19 Pandemie. Das ist gut, denn gerade bei der schnellen Interpretation großer Datenmengen kann KI durch Aufdecken bis dato unbekannter Zusammenhänge wertvolle Beiträge leisten. Allerdings nutzt das schönste selbstlernende System nichts, wenn keine guten Daten vorliegen. Hier hat der Expertenrat der Bundesregierung in seiner 4. Stellungnahme jedoch heftig kritisiert, dass nach wie vor vor allem Echtzeitdaten fehlen, um ein gutes, evidenzbasiertes Pandemiemanagement zu ermöglichen.

Ich begrüße, dass es auch Projekte gibt (z.B. Nr. 66 in Anlage 2), die sich mit der Ergänzung von Formularen durch Chatbots befassen, denn gut gemacht, können solche Chatbots mit multilingualem 24/7 Angebot in natürlicher Sprache den Zugang zu sozialen Leistungen erleichtern. Gerade wer mit der bürokratischen Sprache in Formularen ein Problem oder schlechte Erfahrungen mit Behörden gesammelt hat, kann mit Messenger-artigen Chatbots oft niedrigschwellig und korrekt auch komplexere Formulare ausfüllen – in Form eines Chat-Gesprächs mit dem Formular. Allerdings müssen solche Chatbots dann auch im Sinne der Anspruchsberechtigten entwickelt werden, mit transparenten Algorithmen und unter Beteiligung der Zivilgesellschaft. Ihr Ziel muss zwingend die Maximierung der Anspruchsgewährung für Anspruchsberechtigte sein und nicht, soziale Ausgaben zu minimieren. Natürlich dürfen sie auch Beratungsangebote nicht ersetzen.

Auch unter den über 190 Forschungsvorhaben (siehe Tabelle in Anlage 3) finde ich diverse positive Vorhaben, wie z.B. einige Projekte des BMFSFJ:

- Diversität in der KI

- Souveränität älterer Menschen

- YouCodeGirls (I u. II)

- Chatbot Familie (z.B. f. Zugewanderte sowie Familien)

- KI und Gleichstellung

Mit üppigen Fördermitteln werden diese Projekte jedoch nicht ausgestattet. Die aufgezählten Forschungsprojekte werden insgesamt mit ca. 5,5 Mio. Euro finanziert, insgesamt gibt die Bundesregierung in ihrer Antwort für KI-Forschungsprojekte mehr als 1,8 Mrd Euro an. Es finden sich aber immerhin nennenswerte Förderungen im Bereich „Social Innovation“, die wir als Linksfraktion schon seit Jahren gefordert hatten, sowie zahlreiche Vorhaben, die einen Bezug zu Verbrauchern, Gesundheit, Teilhabe, Bildung, Umwelt oder Verkehr haben.

Eine ausführlichere Auswertung der Forschungsvorhaben hat meine Kollegin Petra Sitte, forschungspolitische Sprecherin der Linksfraktion geschrieben. Sie ist HIER zu finden.

FoSSIL 4.0, KIMoNo, KI-ULTRA – Was ist das?

Unterhaltsam zu lesen waren die diversen Abkürzungen von Projekten, vor allem in Tabelle 3. Hier zum Abschluss meiner Analyse meine persönlichen Highlights:

FoSSIL 4.0: Archäologie? Gesteine? Nein, lichtsensible Sensoren für die Bahn!

= „Faseroptische Sensorik für sicherheitsrelevante (Safety Integrity Level) Bahnanwendungen“ (darauf muss man erst mal kommen!)

KIMoNo: Mode? Textilindustrie? Irgendwas mit Asien oder Japan? Nope!

= „KI-basierte typübergreifende Mobilitätsoptimierung in nonurbanen Regionen“ (man hätte auch ländlicher Raum schreiben können, aber das klang wohl zu profan…)

KI-Ultra: uiuiui, KI im Leistungssport? Nein, es soll nur nicht so langweilig klingen.

= Unternehmenslabore für Transformation und Change im Zusammenhang mit KI

Das war also meine Analyse der Antwort der Bundesregierung auf meine Kleine Anfrage zum Einsatz und zur Förderung künstlicher Intelligenz.

Original-Antwort der Bundesregierung

Die Antwort im Wortlaut ist hier verfügbar (Verschlusssachen-Teile sind geschwärzt) (jeweils pdf):

- Anschreiben und Kommentierung der Bundesregierung

- Anlage 1: Anwendungsfälle von KI in Bundesministerien und nachgeordneten Behörden

- Anlage 2: Angaben zur externen Entwicklung von KI-Systemen

- Anlage 3: Weitere Forschungsvorhaben, Pilotprojekte und Reallabore mit Beteiligung der Bundesministerien und nachgeordneter Behörden